Einleitung

The world´s most valuable resource is no longer oil, but data.

THE ECONOMIST

Der Titel eines Artikels im The Economist vom Mai 2017 verdeutlicht den Stellenwert, den Daten in unserer heutigen Welt einnehmen. Ursprünglich wurde diese Metapher im Zusammenhang mit Kartellstrukturen von großen Digitalunternehmen -ähnlich denen der Ölindustrie- genutzt. Inzwischen ist der Paradigmenwechsel in Bezug auf die „wertvollste Ressource der Welt“ jedoch in allen Branchen und Wirtschaftszweigen ein fester Bestandteil des unternehmerischen Handelns geworden.

Dieser hohe Wert von Daten entsteht vor allem dann, wenn sie eine gewisse Qualität aufweisen. An dieser Stelle setzt ein IT-technisch unterstütztes Datenqualitätsmanagement an.

Nachfolgend wird dieses Whitepaper die wichtigsten Begriffe definieren sowie die Frage klären, warum gute Datenqualität notwendig, messbar und erreichbar ist. ADWEKO gibt in diesem Zusammenhang zudem Einblicke in mögliche Handlungsfelder und erfolgreiche Projektbeispiele.

[1] https://www.economist.com/leaders/2017/05/06/the-worlds-most-valuable-resource-is-no-longer-oil-but-data

2. Datenqualitätsmanagement bei Banken

2.1 Definitionen

Datenqualität beschreibt die Korrektheit, Relevanz und Verlässlichkeit von Daten, abhängig vom Zweck, die die Daten in einem bestimmten Zusammenhang erfüllen sollen.[1]

Datenqualitätsmanagement bezeichnet sämtliche Maßnahmen, die eine vermögenswertorientierte Betrachtung, Steuerung und Qualitätssicherung von Daten in einem Unternehmen ermöglichen. Datenqualitätsmanagement ist eine Teildisziplin einer ganzheitlichen Data Governance Strategie.[2]

[1] https://www.haufe-akademie.de/blog/themen/controlling/datenqualitaetsmanagement-engl-data-quality-management/

[2] https://www.haufe-akademie.de/blog/themen/controlling/datenqualitaetsmanagement-engl-data-quality-management/

2.2 Wertbeitrag aus Risikoaspekten

Nicht erst seitdem der Baseler Ausschuss für Bankenaufsicht im Jahre 2013 die „Grundsätze für die effektive Aggregation von Risikodaten und die Risikoberichterstattung“ (BCBS239) fest in der Regulatorik verankert hat, gibt es viele Gründe eine gute Datenqualität im Unternehmen sicherzustellen.

Auf der einen Seite wirken sich eine gewachsene IT-Infrastruktur, eine Vielzahl von manuellen Eingriffen und langwierigen Prozessen negativ auf die Datenqualität im Unternehmen aus. Auf der anderen Seite liegen hier Potenziale, RTB- und CTB-Kosten zu senken, Synergiepotenziale zwischen verschiedensten Banksteuerungsbereichen zu heben sowie an Agilität und Schnelligkeit zu gewinnen.

Durch gute Datenqualität können vielmehr noch neue Themenfelder erschlossen werden. Dazu zählen Automatisierungsthemen wie durch Robotic Process Automation verschiedenste Formen der Digitalisierung, ein besseres Verständnis der Kundenbedürfnisse und nicht zuletzt Künstliche Intelligenz (KI)[1].

Insgesamt lässt sich konstatieren, dass Unternehmen mit einer hohen Datenqualität sowohl bestehende als auch neue Prozesse/Geschäftsfelder besser abdecken und damit Kosten senken und neue Erträge generieren können und werden. Banken können darüber hinaus ihre institutseigenen Risiken besser abschätzen und frühzeitiger gegensteuern. In der Konsequenz kann so ein Zusammenbruch des Instituts und eine Kaskade auf Wirtschaft und Gesellschaft verhindert werden – sozusagen BCBS239 für alle.

[1] Ohne ausreichende Datenqualität kann eine KI nicht angelernt werden.

2.3.1 Analyse des Status Quo

Um Datenqualität sinnvoll zu messen und zu verbessern, ist eine Analyse des Status Quo unabdingbar. Hier empfiehlt sich, gemeinsam mit einer unternehmensweiten BI-Gruppe, Data Ownern/Stewards und Systemexperten eine Bestandsaufnahme, beispielsweise in Form von Workshops, durchzuführen. Im Rahmen dessen können Auswertungen zu aufgetretenen DQ-Problemen aus Incident Management Tools, wie beispielsweise SAP Solution Manger oder ServiceNow, einen wertvollen Beitrag in der Analyse des Status Quo leisten. Anhand der Ergebnisse lassen sich erste Aufsatzpunkte ermitteln, um

- bestehende DQ-Handlungen und Datenmodelle zu verbessern und

- neue DQ-Prüfungen aufzusetzen.

Nach erfolgreicher Analyse des IST-Status und fachlicher Skizzierung möglicher, neuer Anforderungen, kann abschließend die technische Umsetzung erfolgen.

2.3.2 Messung

2.3.2.1 Datenqualitätsdimensionen

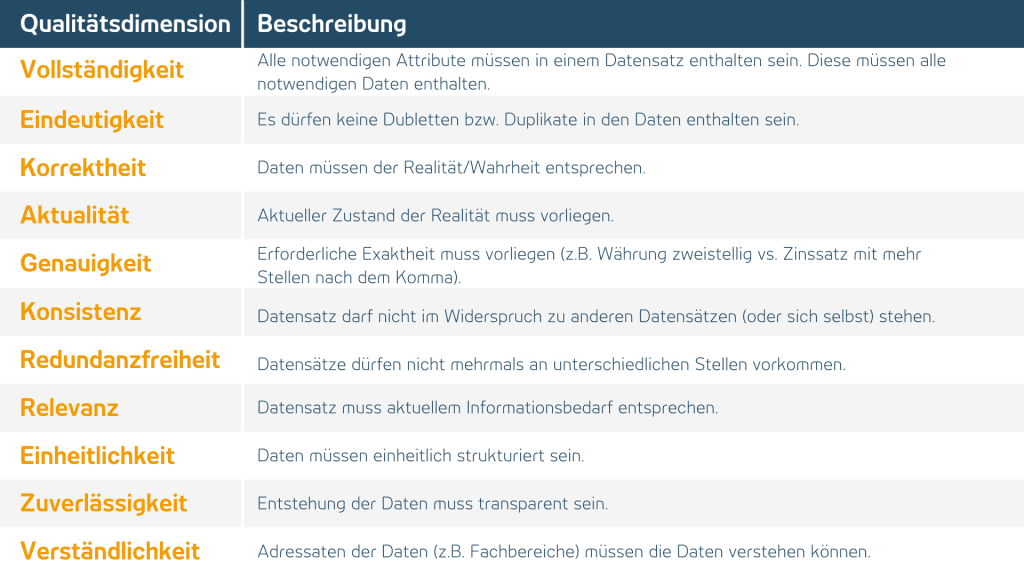

Um die Qualität eines Produktes (in diesem Fall Daten) bewerten und steuern zu können, muss diese messbar sein. Dabei haben sich, bezogen auf Datenqualität, einige Qualitäts-Dimensionen herausgebildet, die im Folgenden kurz beschrieben werden.[1]

[1] Die Messung der einzelnen Dimensionen wird unter folgendem Link gut verdeutlicht: Datenqualität messen: Mit 11 Kriterien Datenqualität quantifizieren (business-information-excellence.de)

2.3.2.2 Beispiel Friday Afternoon Measurement

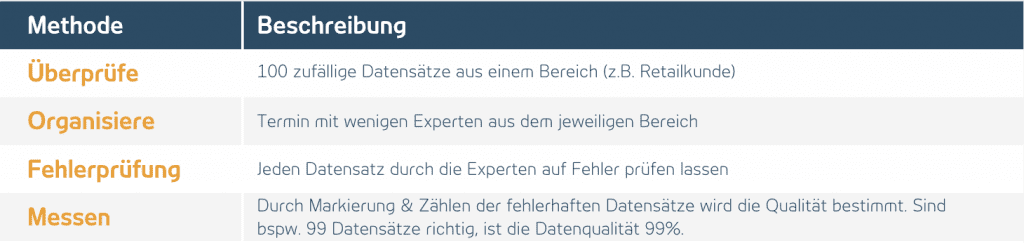

Eine schnelle und unkomplizierte Methode zur Messung von Datenqualität liefert das „Friday Afternoon Measurement“ von Thomas C. Redman[1]. Diese untergliedert sich in vier Schritte:

2.3.2.2 Herausforderungen

Datenqualität lässt sich also auf vielfältige Weise messen. Es ergeben sich jedoch einige Schwierigkeiten bei der Messung:

- Andauernder Prozess notwendig –

Es reicht nicht, alle Daten einmalig zu prüfen (was bereits sehr aufwendig ist). Vielmehr muss die Datenqualität fortlaufend überprüft werden. - Datenmenge nimmt stetig zu –

Durch neue aufsichtsrechtliche Anforderungen (z.B. Ana-Credit oder Finrep Meldung) und den Möglichkeiten von Big Data / Data Analytics nimmt die Menge der zu prüfenden Daten stetig zu - Near Time Reporting –

Das Bedürfnis nach möglichst aktuellen Daten erfordert eine schnelle Datenverarbeitung. Dadurch bleibt deutlich weniger Zeit für aufwendige Datenqualitätsprüfungen.

3. Mögliches Projektvorgehen zur Erstellung neuer Datenqualitäts-Prüfungen

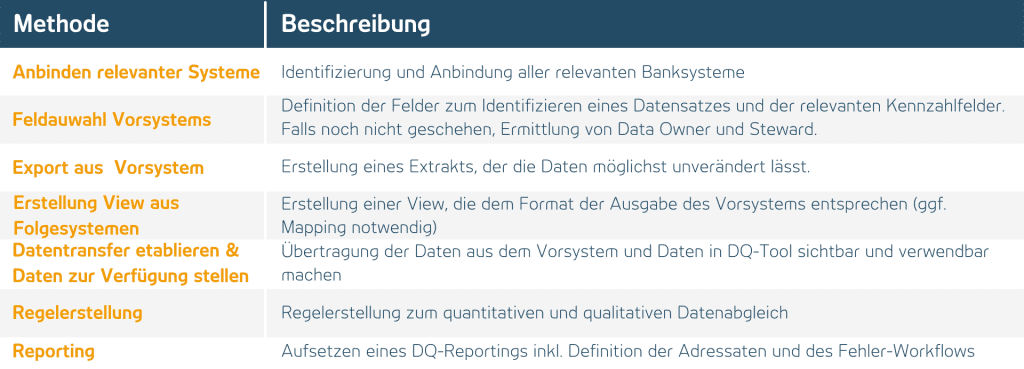

Für die Neuerstellung von DQ-Prüfregeln sind einige grundlegende Schritte notwendig. Diese sind nachfolgend dargestellt:

3.1 Referenzen

Wir bei ADWEKO bieten Ihnen Experten mit langjähriger Erfahrung und Expertise in der Einführung von DQ-Maßnahmen bei Banken.

3.1.1 Projektbeispiel 1

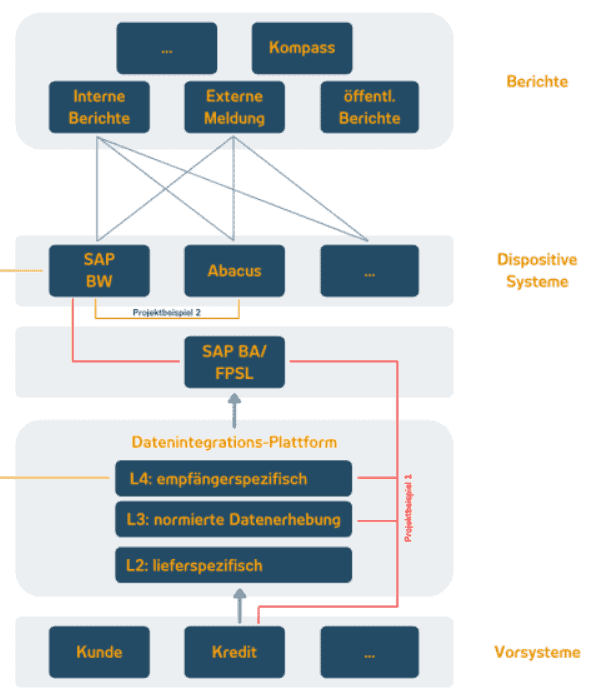

Implementierung von automatisierten Datenqualitätsregeln zur Überprüfung der Konsistenz und Vollständigkeit über die Retaildarlehen-Lieferstrecke – Im Rahmen der Einführung eines neuen Darlehenssystems für das Retail-Geschäft wurden neben dem Neugeschäft auch vorhandene Darlehensbestände aus dem bisherigen Darlehensverfahren migriert. Zur Messung und Überprüfung der Datenqualität haben unsere ADWEKO-Consultants automatisierte Systemübergangsprüfungen über die IFRS-Lieferstrecke implementiert. Ziel war es, alle relevanten AFI-Kennzahlen über separate DQ-Regeln über die Lieferstrecke (Vorsystem Darlehen, Datenintegrationsplattform, SAP BA, SAP BW) hinweg betragsmäßig abzugleichen. Die AFI-Kennzahlen bezeichnen die Kennzahlen btw. Sachverhalte je Einzelgeschäft, welche im Nebenbuch im Zuge der AFI-Verarbeitung betragsmäßig i.S.d doppelten Buchführung für jedwede Geschäftsvorfälle gebucht werden und zum Ultimo summiert in das SAP BW extrahiert werden.

3.1.2 Projektbeispiel 2

Etablierung konzerneinheitlicher Überleitungs- und Plausibilisierungsregeln für definierte Key Risk Measures (KRM) –

Die Ermittlung der verschiedenen KRMs oder auch verschiedenen fachlichen Spielarten eines KRM liegen einer komplexen und heterogenen IT-Systemlandschaft zu Grunde. Dies kann potenziell dazu führen, dass selbst bei einheitlicher fachlicher Definition zwischen verschiedenen Systemen Inkongruenzen entstehen, die nicht fachlichen, sondern technischen Ursprungs sind. Ziel der zu implementierenden DQ-Prüfungen war es daher, Daten aus den Bereichen des Risiko-/Finanzcontrollings, des Rechnungswesens und des Meldewesens über die verschiedenen IT-Systeme betragsmäßig zu validieren. Hierzu haben wir bei unserem Kunden Datenqualitätsregeln in Form von automatisierten End-to-End Abgleiche zur Sicherstellung der Konsistenz der Daten zwischen dispositiven Systemen SAP BW und ABACUS implementiert.

4. ADWEKO Handlungsfelder

Wir unterstützen Sie beim Aufsetzen und Verbessern von automatisierten Datenqualitätsregeln über die bankweite IT-Lieferstrecke sowie bei der Auswahl und Einführung von DQ- und MDM-Tools.

Um die Konformität des Tools zur bankweiten-Architektur und -Infrastruktur zu gewährleisten, sind für den Auswahlprozess der BI-Toolsuite in erster Linie technische Kriterien relevant. Neben diesen technischen Kriterien sind allerdings auch fachliche Anforderungen und funktionale Kriterien (z.B. Reportingmöglichkeiten, Standard- und Adhoc-Reporting, User-Experience, Drill-Funktionen oder Berechtigungsstruktur) sowie nicht-funktionale Kriterien (wie z.B. Schulungsbedarf, Support durch Anbieter, Release-Zyklen und Kosten) einzubeziehen. Moderne Datenmanagement Systeme bieten zahlreiche Möglichkeiten ein umfangreiches Datenqualitätsmanagement zu implementieren.

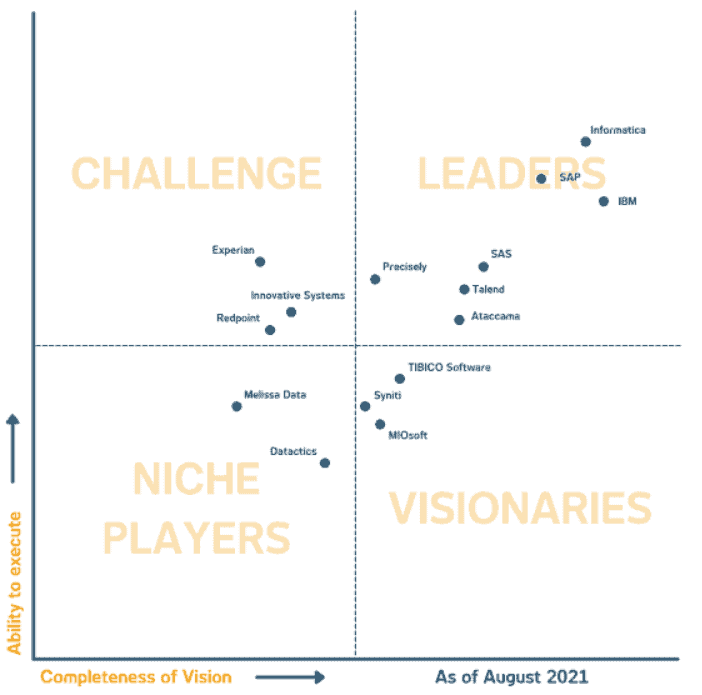

Der Gartner Magic Quadrant zeigt im September 2021 Informatica, SAP und IBM als führendes Toolanbieter. Am Markt sind jedoch eine Vielzahl weiterer Anbieter zu finden und je nach Use-Case auszuwählen.

Fazit

Daten sind ein zentrales Asset jedes Finanzinstituts. Die Menge der zu verarbeitenden Daten nimmt stetig zu. Infolgedessen steigt die Relevanz eines einheitlichen Daten- und Datenqualitäts-Managements. Dies schlägt sich beispielsweise auch in den Anforderungen der Aufsicht im Regelwerk zu BCBS 239 nieder, in dem genau dieses einheitliche Vorgehen für alle Risikoarten gefordert wird. Ein solches Datenqualitätsmanagement kann effizient nur über eine entsprechende IT-technische Unterstützung sichergestellt werden. Die aktuellen Datenqualitätsprozesse vieler Banken konzentrieren sich auf anlassbezogene Datenqualitätsprüfungen. Um von Datenqualitätsmessung jedoch sinnvoll zu profitieren, sollte die aktuelle Prozess- und Systeminfrastruktur vollständig durch Datenqualitätsprüfungen validiert und erweitert werden. In diesem Zusammenhang entwickelt ADWEKO gemeinsam mit Kunden individuelle Lösungen unter Verwendung modernster BI-Tools.

Tobias Scholz

Managing Consutlant bei ADWEKO

0 Kommentare